ฟังพอดคาสต์เรื่องอื่นของเอสบีเอสไทยที่นี่

องค์กรเพื่อสังคม Sisterworks ในเมลเบิร์นได้ช่วยให้ผู้หญิงที่เป็นผู้อพยพและผู้ลี้ภัยเข้าถึงตลาดแรงงานมานานกว่าทศวรรษ

หลักสูตรฝึกอบรมที่นี่เน้นทั้งทักษะด้านบริการลูกค้า งานบริการ การเข้าสังคม รวมถึงการเขียนเรซูเม่ การสัมภาษณ์ และการสร้างเครือข่าย เพื่อให้ผู้หญิงพร้อมเข้าสู่โลกการทำงาน

อิฟริน ฟิตท็อก ผู้บริหารของ Sisterworks เล่าว่า ช่วงปลายปีที่ผ่านมา ผู้เข้าฝึกอบรม 9 คนต้องเจอกับรูปแบบการสัมภาษณ์ที่ไม่เคยเผชิญมาก่อน

“เราค่อนข้างตกใจ ตอนที่ส่งพวกเธอไปสัมภาษณ์งาน แต่กลับไม่มีใครผ่านเลย พอตรวจสอบดูจึงพบว่า การสัมภาษณ์ไม่ได้เป็นแบบตัวต่อตัว แต่เป็นการสัมภาษณ์ผ่านวิดีโอหรือระบบ AI ซึ่งพวกเธอไม่เคยเจอมาก่อน เลยไม่รู้ว่าจะต้องรับมือยังไง”

เรื่องที่เกี่ยวข้อง

ออสเตรเลียผลิต 'แอบบี' หุ่นยนต์ดูแลผู้สูงอายุ

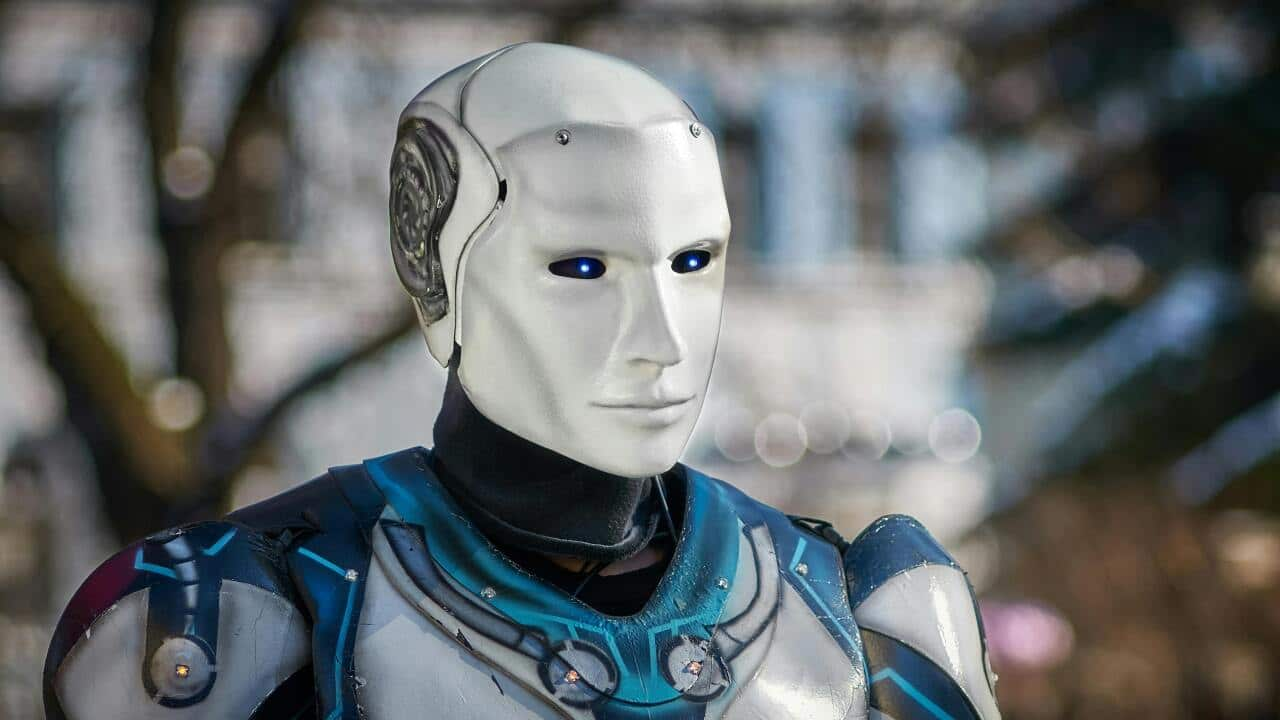

และผู้สมัครงานจำนวนมากแชร์ประสบการณ์ “หุ่นยนต์สัมภาษณ์” ลงโซเชียลมีเดียเช่นกัน

การสัมภาษณ์กับหุ่นยนต์หมายความว่าผู้สมัครต้องตอบคำถามกับระบบอัตโนมัติ แทนการพูดคุยกับมนุษย์

ฟิตท็อกระบุว่า การสัมภาษณ์แบบนี้อาจกลายเป็นอุปสรรคที่เพิ่มขึ้นมาสำหรับผู้อพยพหรือผู้ลี้ภัย

“อุปสรรคมีทั้งเรื่องภาษาอังกฤษที่ไม่ใช่ภาษาแม่ของพวกเธอ และทักษะดิจิทัลที่บางคนอาจยังไม่ถนัด ต้องคอยกดปุ่ม คอยดูเวลานับถอยหลัง สิ่งเหล่านี้เพิ่มแรงกดดันให้มากขึ้น โดยเฉพาะเมื่อเห็นเวลานับถอยหลังตรงหน้า มันทำให้เครียดและตื่นตระหนก”

ข้อมูลจากรายงานของแนวทางการใช้ปัญญาประดิษฐ์อย่างรับผิดชอบในออสเตรเลีย (Australian Responsible AI) ระบุว่า ในปี 2024 องค์กรร้อยละ 43 ใช้ AI ในกระบวนการสรรหาบุคลากร (recruitment) ในระดับ “ปานกลาง” และอีกร้อยละ 19 ใช้ AI อย่าง “เข้มข้น”

Sisterworks จึงได้นำการฝึกสัมภาษณ์ผ่านวิดีโอมาใส่ในหลักสูตรด้วย

ฟาเตเมห์ ซาห์รา ฮาซราติ ผู้อพยพจากอิหร่าน เป็นหนึ่งในผู้เข้าอบรมรุ่นล่าสุด

AI เข้ามามีบทบาทกับชีวิตเรามากขึ้นทุกวัน เราทุกคนจึงต้องเรียนรู้ ปรับตัว และเปิดใจรับความท้าทายเพื่อพัฒนาตัวเองฟาเตเมห์กล่าว

AI มักถูกมองว่าเป็นเครื่องมือช่วยประหยัดเวลาและค่าใช้จ่ายในการจ้างงาน แต่ความกังวลเรื่องความเสี่ยงในการเลือกปฏิบัติก็มีมากขึ้นเช่นกัน

ดร.นาตาลี เชียร์ด จากคณะนิติศาสตร์ มหาวิทยาลัยเมลเบิร์น เป็นผู้นำทีมวิจัยที่ตีพิมพ์ผลการศึกษาเมื่อวันที่ 14 พฤษภาคมที่ผ่านมา ชี้ให้เห็นว่า AI อาจกลายเป็นอุปสรรค สำหรับผู้สมัครหลายกลุ่ม

“ระบบ AI บางตัวไม่เอื้อต่อผู้สมัครที่มีอายุมาก ผู้หญิง ผู้ใช้ภาษาอังกฤษเป็นภาษาที่สอง หรือผู้มีความพิการ บางระบบยังใช้ข้อมูลอย่างช่องว่างระหว่างการทำงานเพื่อคัดกรอง ซึ่งอาจเป็นการเลือกปฏิบัติโดยไม่รู้ตัว เพราะผู้หญิงจำนวนมากมีช่องว่างนั้นจากการลางานเพื่อดูแลครอบครัว”

ดร. เชียร์ดยังอธิบายว่า การประเมินผลด้วย AI ในวิดีโอสัมภาษณ์มักใช้การถอดเสียง ซึ่งระบบถอดเสียงอัตโนมัติมักมีปัญหาเมื่อผู้พูดมีสำเนียงหรือใช้ภาษาอังกฤษไม่คล่อง

“AI ไม่ได้ประเมินจากวิดีโอโดยตรง แต่จะถอดเสียงออกมาเป็นข้อความ แล้วใช้ระบบประเมินคำตอบ ซึ่งระบบถอดเสียงมักทำงานได้ไม่ดีนักกับผู้ที่มีสำเนียงหรือใช้ภาษาอังกฤษเป็นภาษาที่สอง”

อย่างไรก็ตาม ศาสตราจารย์แอนเดรียส ไลบ์บรันดท์ จากมหาวิทยาลัยโมนาชกล่าวว่าหากออกแบบระบบอย่างเหมาะสม AI อาจมีอคติน้อยกว่ามนุษย์

เขายกตัวอย่างการศึกษาจากสหรัฐฯ ที่พบว่า ผู้หญิงและผู้สมัครที่ไม่ใช่เชื้อสายแองโกลมีแนวโน้มที่จะสมัครงานมากขึ้น หากทราบว่าองค์กรใช้ AI คัดเลือก

“ผู้หญิงหรือชนกลุ่มน้อยไม่ได้คิดว่า AI มีอคติเสมอไป บางคนกลับรู้สึกว่ามีอคติน้อยกว่าการเจอกับคนสัมภาษณ์จริง ๆ เสียอีก”

อย่างไรก็ตาม เขากังวลเรื่องความไม่โปร่งใสและอคติที่อาจแฝงอยู่ในข้อมูลที่ใช้ฝึกระบบ

“AI เรียนรู้จากข้อมูลที่ได้รับ ซึ่งหากข้อมูลนั้นมีอคติ เช่น มาจากองค์กรที่มีความลำเอียงต่อผู้หญิง ก็อาจสะท้อนอคติเหล่านั้นออกมาในระบบ”

เรื่องที่เกี่ยวข้อง

บทบาทของ AI กับอนาคตของระบบสาธารณสุขออสเตรเลีย

และประเด็นเรื่องชุดข้อมูลที่ลำเอียงนี้ยังพบในงานวิจัยของเชียร์ดเช่นกัน

“ระบบ AI ประเภทนี้มักถูกพัฒนาในต่างประเทศ โดยใช้ข้อมูลจากประชากรที่ไม่สอดคล้องกับของออสเตรเลีย จึงอาจใช้งานได้ไม่ดีนักกับบางกลุ่ม เช่น กลุ่มผู้ลี้ภัย ผู้อพยพเพศหญิง หรือชาวอะบอริจิน”

ขณะนี้ มีการเรียกร้องให้รัฐบาลออสเตรเลียกำกับดูแลการใช้ AI ในการสรรหาบุคลากรอย่างจริงจัง

แคทเธอรีน ฮันเตอร์ ผู้บริหารของ Diversity Council Australia กล่าวว่า

“ด้วยอัตราการใช้งานที่สูงและการพัฒนาเทคโนโลยีที่ดำเนินการอย่างรวดเร็ว เรากังวลว่าองค์กรที่ใช้ AI ยังไม่ได้พิจารณาประเด็นจริยธรรมอย่างรอบด้าน”

ทั้งนี้ ผู้เชี่ยวชาญย้ำว่านายจ้างควรมีความรับผิดชอบ และเปิดเผยกระบวนการอย่างโปร่งใส และควรมั่นใจว่าอัลกอริทึมของตนจะไม่ก่อให้เกิดการเลือกปฏิบัติในกระบวนการจ้างงาน

ติดตามเอสบีเอส ไทย ได้อีกทาง เว็บไซต์ | เฟซบุ๊ก | อินสตาแกรม

ฟังพอดคาสต์ของเอสบีเอส ไทยผ่านแอปพลิเคชัน SBS Audio ดาวน์โหลดจาก Apple Store หรือจาก Google Play